Audiocodierungsstrategien für Cochlea-Implantate

Das Cochlea-Implantat (CI) ist eine elektronische Innenohrprothese, die es gehörlosen oder ertaubten Menschen ermöglicht, erstmals ein Hörvermögen zu erlangen oder wiederzuerlangen. Das Alter der Patienten reicht vom Kleinkind bis hin zum hohen Erwachsenalter und bringt für die behandelten Personen eine enorme Verbesserung der Lebensqualität mit sich [1, 2].

Cochlea-Implantate sind allerdings noch nicht geeignet, die Probleme aller Alltagssituationen zu meistern. Die Qualität des Hörerlebnisses für Musik oder in lauten Umgebungen ist stark eingeschränkt. Auch ein Richtungshören ist nicht immer möglich.

Um diese Aspekte des CIs berücksichtigen zu können, wird weiter an Verbesserungsmöglichkeiten in Software und Hardware des Implantats geforscht.

Das Cochlea-Implantat (CI) ist eine elektronische Innenohrprothese, die es gehörlosen oder ertaubten Menschen ermöglicht, erstmals ein Hörvermögen zu erlangen oder wiederzuerlangen. Das Alter der Patienten reicht vom Kleinkind bis hin zum hohen Erwachsenalter und bringt für die behandelten Personen eine enorme Verbesserung der Lebensqualität mit sich [1, 2].

Cochlea-Implantate sind allerdings noch nicht geeignet, die Probleme aller Alltagssituationen zu meistern. Die Qualität des Hörerlebnisses für Musik oder in lauten Umgebungen ist stark eingeschränkt. Auch ein Richtungshören ist nicht immer möglich.

Um diese Aspekte des CIs berücksichtigen zu können, wird weiter an Verbesserungsmöglichkeiten in Software und Hardware des Implantats geforscht.

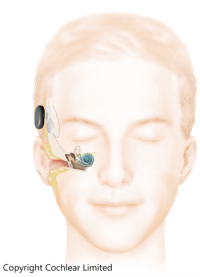

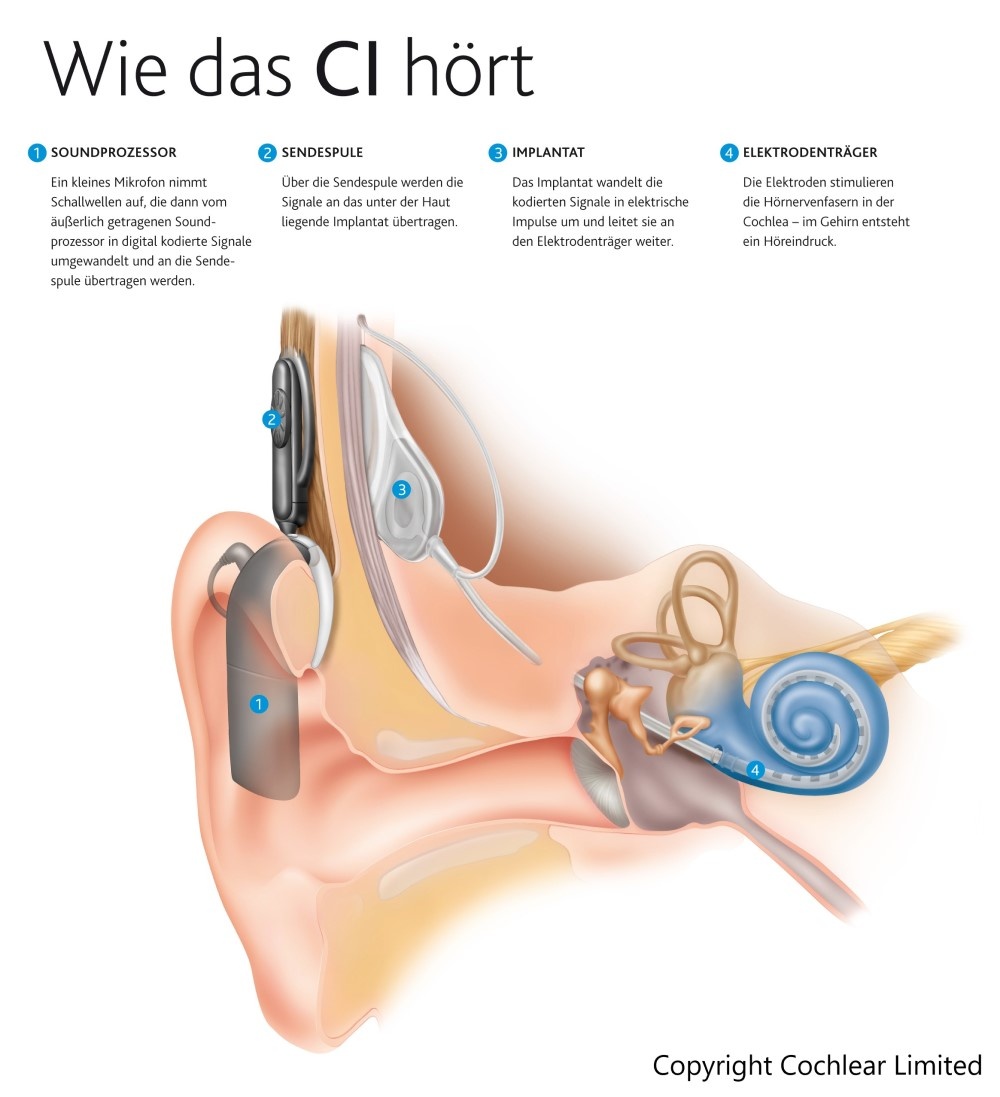

Für die Beschreibung eines CI-Systems kann man eine Unterscheidung in zwei wesentliche Bestandteile vornehmen: Ein Soundprozessor mit Sendespule an Ohr und Kopf des Patienten und das Implantat unter der Haut. Bei den Prozessoren unterscheidet man zwischen am Kopf getragenen und HdO-Spoundprozessoren (Hinter-dem-Ohr). Dieser ist meist mit zwei Mikrofonen ausgestattet, um Hintergrundgeräusche minimieren zu können. Eine Sendespule am Kopf des Patienten sorgt dafür, dass die vom Soundprozessor digital codierten Signale induktiv zur Empfangsspule unter die Haut gelangen. Die so erhaltenen digitalen Informationen werden im Implantat in elektrische Signale umgewandelt. Das elektrische Signal steuert das aus bis zu 22 Elektroden bestehende Elektrodenarray des Cochlea-Implantats an. Dieses Elektrodenarray wird operativ in der Cochlea des Patienten plaziert. Durch die Ansteuerung der Elektroden erfolgt eine Stimulierung der Hörnervenfasern. Daraufhin feuern die Nervenzellen, wodurch Sprache oder Musik wahrgenommen werden können.

Im Rahmen des Forschungsprojektes zum Thema

Audiocodierungsstrategien für Cochlea-Implantate, sollen die derzeit in Soundprozessoren

verwendeten Codierungsstrategien optimiert und neue Strategien erforscht werden.

Damit auch Forscher ohne Zugang zu Patienten ihre Algorithmen testen können, wollen wir eine

neue Synthese implementieren, die mit dem Hörempfinden von CI-Patienten korreliert. Dafür wollen

wir die Funktionsweise des menschlichen Gehörs als Vorbild nehmen und Faktoren wie Kanalinteraktion

und Refraktärzeit bei der Signalsynthese berücksichtigen.

Zur Umsetzung der Patientenlosen Tests entsteht im Sommer 2019 an der Ostfalia Hochschule mit

der Renovierung des reflexionsarmen Raumes ein Ort der akustischen Möglichkeiten für vielseitige

Test- und Simulationsanwendungen. Ein Anwendungsbeispiel für ein Solches Testvorhaben ist ein

automatisierter Hörtest für die Algorithmen von CIs. Darüber hinaus sind auch Messungen für

Hörgeräte oder Frequenzgangmessungen und vieles mehr möglich.

Damit die von einem CI aufgenommenen Schallwellen in ein für unser Gehirn verwertbares Signal transformiert werden können, benötigt es eine Verarbeitung durch Audiocodierungsstrategien. Es gibt verschiedene Ansätze diese Aufgabe zu bewältigen.

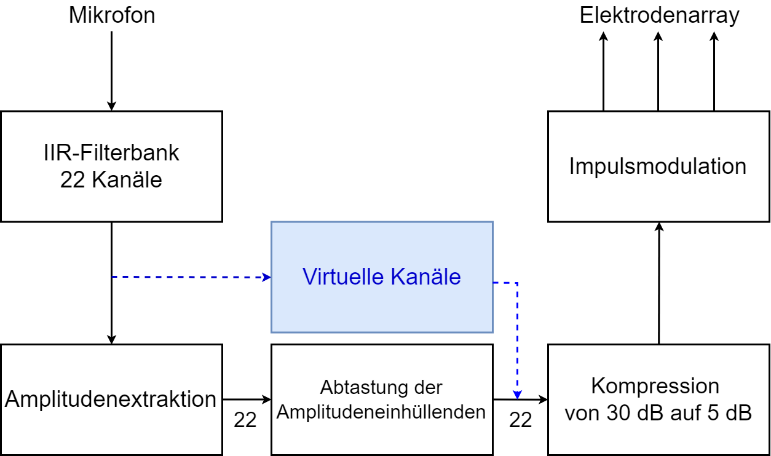

Continus Interleaved Sampling (CIS)

Bei der CIS-Strategie [3] werden alle Elektroden in der Cochlea des Patienten einzeln angesteuert. Das bedeutet, dass immer nur eine Elektrode mit einem Stromimpuls Nervenfasern in der Cochlea stimuliert. Dadurch sollen Interaktionen zwischen benachbarten Elektroden verhindert werden. Zu jedem Zeitpunkt der Pulssequenz ist nur ein Impuls mit einer definierten Pulsbreite gleichzeitig aktiv.

Die wert- und zeitkontinuierlichen Schallwellen werden von einem Mikrofon aufgenommen und mit Hilfe eines A/D-Wandlers in ein digitales, zeit- und wertdiskretes, elektrisches Signal umgewandelt. Anschließend wird das Signal in 22 Kanäle eingeteilt. Diese Einteilung in die verschiedenen Kanäle erfolgt durch eine IIR-Filterbank, die aus 22 Bandpassfiltern besteht. Anschließend wird in dem Block Amplitudenextraktion von dem bandpassgefilterten Zeitsignal die Einhüllende berechnet. Diese wird danach unterabgetastet, so dass es für jeden Impuls einen Amplitudenwert gibt. Mittels einer logarithmischen Kompressionsfunktion wird für die Kanäle der Dynamikbereich der akustischen Amplitude (ca. 30dB bei Sprache) auf ca. 5dB komprimiert und somit an den wahrnehmbaren Dynamikbereich von CI-Trägern angepasst. Dies ist normalerweise ein patientenspezifischer Vorgang. Zum Schluss wird die komprimierte Einhüllende mit den Impulsen moduliert und an die Elektroden gesendet.

Die CI-Strategie kann um virtuelle Kanäle erweitert werden. Dies wird durch den blauen Pfad im Blockschaltbild dargestellt. Durch virtuelle Kanäle kann die Freuenzauflösung bis zu einem gewissen Grad erhöht werden.

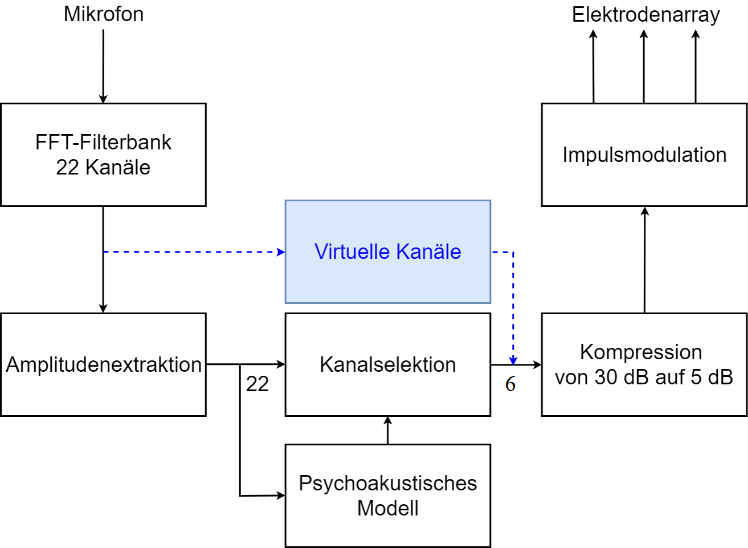

Psychoacoustic Advanced Combinational Encoder (PACE)

Bei der PACE-Strategie [4] wird mit Hilfe eines psychoakoustischen

Modells bestimmt, welche Elektroden aktiviert werden. Simultan zur Vorgehensweise des

CIS-Algorithmus, werden die Schallwellen zunächst diskretisiert. Anschließend wird das digitale

Audiosignal mit einer FFT-Filterbank in 22 Kanäle zerlegt. Auch der Block Amplitudenextraktion

funktioniert wie in CIS beschrieben. Danach werden mit dem psychoakustischen Modell die Kanäle

selektiert, deren Informationsgehalt für das menschliche Gehör am höchsten ist. Als Kriterium dafür

wird die spektrale Maskierung berücksichtigt.

Eine Darstellung dieser Kanalselektion bringt Aufschluss über die Wirkungsweise der Maskierung. Die Schwarz markierten Kanäle werden vom Algorithmus ausgewählt. Es ist zu sehen, dass einige Kanäle trotz einer hohen Amplitude nicht ausgewählt werden. Der Grund dafür ist, dass die Kanäle von den bereits ausgewählten Kanälen maskiert wurden und dadurch nicht mehr von Menschen wahrnehmbar sind. Man nennt dieses Vorgehen auch Maskierungseffekt oder Verdeckung. Nachdem die Kanäle ausgewählt wurden, werden die Amplituden wie bei der CIS-Strategie komprimiert, mit elektischen Impulsen moduliert und an das Elektrodenarray gesendet. Auch bei dieser Strategie kann das Modell um virtuelle Kanäle erweitert werden. Dies ist mit dem blauen Pfad im obigen Blockschaltbild dargestellt.

Virtuelle Kanäle

Durch die Anzahl an Elektroden ist die spektrale Auflösung stark

limitiert. Trotz dieser Limitierung ist es Cochlea-Implantat-Trägern möglich, Sprache in ruhiger

Umgebung zu verstehen. Gibt es allerdings viele Nebengeräusche, wie z.B. in einer Bar, ist eine

höhere spektrale Auflösung hilfreich. Die Erkennung von Instrumenten und die Wahrnehmenung von

Melodien ist ebenfalls nur mit einer erhöhten spektralen Auflösung möglich. Townshend et al. [5]

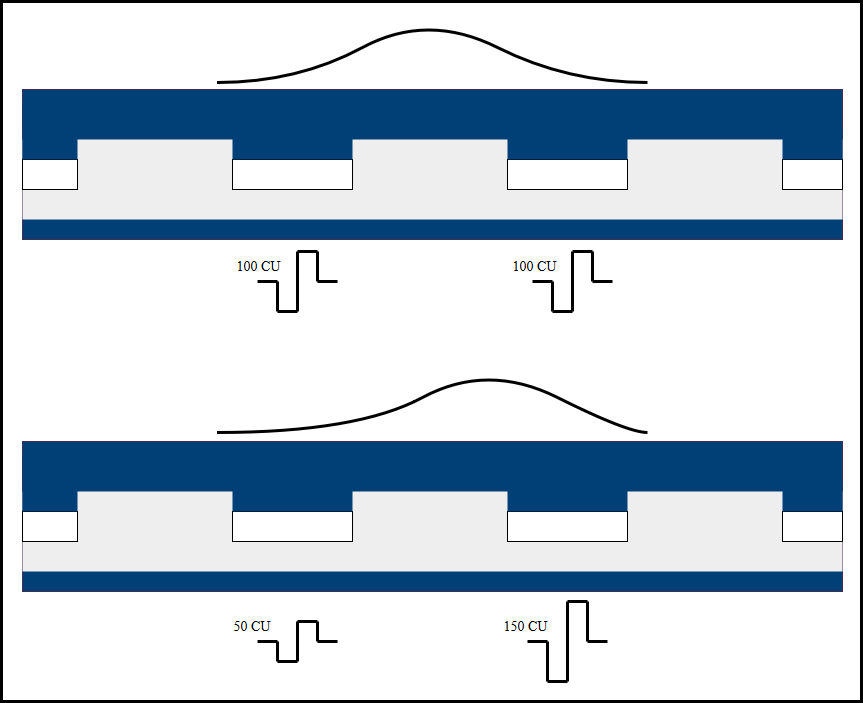

berichteten 1987, dass zusätzliche Tonhöhen von Patienten wahrgenommen werden, wenn zwei

benachbarte Elektroden gleichzeitig angesteuert werden. Welche Tonhöhe wahrgenommen wird, kann

durch den Strom, der durch die Elektroden fließt, gesteuert werden. Die wahrgenommene Lautstärke

bleibt dabei gleich, solange die Summe der durch die beiden Elektroden fließenden Ströme konstant

ist [6].

Vocoder

Ein Vocoder bietet die Möglichkeit die elektrischen Impulse des Elektrodenarrays in ein hörbares Audiosignal zun transformieren. die sinusoidale Synthese ist ein Verfahren für die Realisierung des Vocoders. Hierbei wird für jede Elektrode ein Sinussignal erzeugt, dessen Frequenz gleich der Mittenfrequenz des entsprechenden Bandes ist. Jedes dieser Signale wird mit der Amplitude des Impulses der zugehörigen Elektrode moduliert. Anschließend wird die Summe aller Sinussignale berechnet. Dadurch entsteht ein Audiosignal, welches für Normalhörende hörbar ist. Da die Verarbeitung frameweise stattfindet, muss zwischen den Frames sowohl die amplitude, als auch die Frequenz interpoliert werden, um Sprünge im Audiosignal zu vermeiden.

Die Erzeugung eines Audiosignals basiert bei diesem Vocoder im Wesentlichen auf den Amplituden der Impulse. Effekte, die durch die Änderung der Impulsrate auftreten, werden nicht berücksichtigt. Dafür bedarf es eines Vocoders, der wichtige Eigenschaften des Gehörs einberechnet. Mit dem modifizierten Vocoder kann bei Tests mit Normalhörenden das Hörempfinden mit dem von Cochlea-Implantat-Trägern stark korrelieren.

Um dieses Ziel zu erreichen, soll eine Vorstufe vor den zurzeit genutzten Vocoder geschaltet werden. Diese sollte das, durch die Impulse, sich ausbreitende elektrische Feld simulieren. Dadurch kann bestimmt werden, in welchem Bereich der Cochlea Hörnerven durch einen Impuls aktiviert werden. So wird das Übersprechen von Elektroden berücksichtigt. Außerdem ist das Einbeziehen der Refraktärzeit (Erholungszeit) der Hörnerven sinnvoll. Durch diese Erweiterung ist es möglich, dass Hörnerven trotz eines elektrischen Impulses nicht aktiviert werden, da sie sich noch vor der vorherigen Aktivierung erholen müssen. Die Veränderung der Tonhöhe sowie die der Lautstärke in Abhängigkeit der Impulsrate ist ebenfalls ein wichtiger Mechanismus, der berücksichtigt werden muss. Eine ähnliche Vorstufe wurde in [9] beschrieben und realisiert.

In dem reflexionsarmen Freifeldraum der Hochschule sollen sowohl

subjektive Hörtests mit Probanden als auch automatisierte Sprachverständlichkeitstests durchgeführt

werden. Dafür wird ein 8-Kanaliges Lautsprechersystem aufgebaut. Mit diesem System wird ein

Kunstkopf beschallt, in dessen Ohren Mikrofone mit Ohrsimulatoren verbaut sind. Das von diesen

Mikrofonen aufgenommene Signal wird anschließend mit einer Spracherkennung analysiert. So können

Sprachverständlichkeitstests automatisch durchgeführt werden. Der Vorteil dieses Systems liegt

darin, dass neue oder modifizierte Algorithmen zunächst ohne Probanden getestet werden können. Wenn

der Test erfolgreich war, können anschließend subjektive Tests mit Probanden durchgeführt werden.

Aktuell wird der reflexionsarme Raum renoviert.

[1] D. S. Dalton et al., „The impact of hearing loss on quality of life in older adults“ (eng), The Gerontologist, Jg. 43, Nr. 5, S. 661–668, 2003.

[2] L. Roland et al., „Quality of Life in Children with Hearing Impairment: Systematic Review and Meta-analysis“ (eng), Otolaryngology--head and neck surgery : official journal of American Academy of Otolaryngology-Head and Neck Surgery, Jg. 155, Nr. 2, S. 208–219, 2016.

[3] B. S. Wilson et al., „Better speech recognition with cochlear implants“ (eng), Nature, Jg. 352, Nr. 6332, S. 236–238, 1991.

[4] W. Nogueira, A. Büchner, T. Lenarz und B. Edler, „A Psychoacoustic “NofM”-Type Speech Coding Strategy for Cochlear Implants“, EURASIP Journal on Applied Signal Processing, S. 3044–3059, 2005.

[5] B. Townshend, N. Cotter, D. van Compernolle und R. L. White, „ Pitch perception by cochlear implant subjects“ (eng), The Journal of the Acoustical Society of America, Jg. 82, Nr. 1, S. 106–115, 1987.

[6] Advanced Bionics, „HiRes Fidelity 120 Sound Processing: Implementing Active Current Steering for Increased Spectral Resolution in Harmony HiResolution Bionic Ear Users“, 2009.