Ostfalia entwickelt selbstlernendes Transportsystem

Intelligente Systeme für Energie und Mobilität

An der Fakultät Fahrzeugtechnik der Ostfalia Hochschule für angewandte Wissenschaften beschäftigt sich ein Projektteam unter der Leitung der Professoren Dr. Harald Bachem und Dr. Bernd Lichte mit der Entwicklung eines selbstlernenden Transportsystems. Die Erkenntnisse aus diesem und anderen Forschungsprojekten finden unmittelbar Einzug in die Lehrveranstaltungen der beiden oben genannten Professoren, sodass Studierende der Fahrzeugtechnik eine praxis- und forschungsnahe Ausbildung auf den Gebieten der aktiven und passiven Fahrzeugsicherheit sowie der Regelungstechnik erhalten. Auf Basis dieser und weiterer Forschungsprojekte ist das Institut für Fahrzeugbau Wolfsburg (IFBW) in den Bereichen der Robotik, Sensorik und fahrerlosen Transportfahrzeuge (FTF) als Kompetenzstandort der Initiative „I4.0-Testumgebungen für KMU (I4KMU)“ gelistet, welche vom Bundesministerium für Bildung und Forschung gefördert wurde.

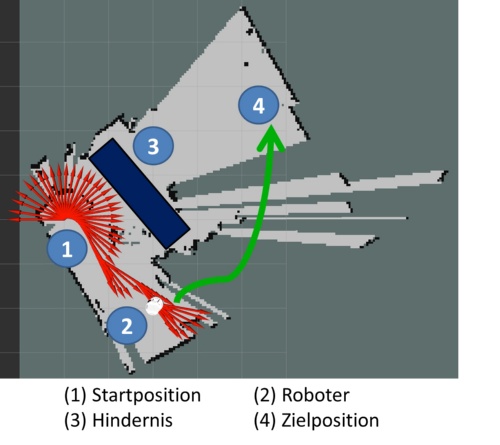

Im Projekt „Selbstlernendes Transportsystem (SeLeTraSys)“ arbeitet das Team an hochautomatisierten Transportfahrzeugen, die ihre Routenplanung ohne physische Leitliniensysteme durchführen können. Vergleichbare Systeme arbeiten derzeit auf der Basis von reflektierenden, auf dem Boden aufgeklebten, Linienführungen oder anhand von induktiven Leiterbahnen. Einsatz finden Systeme dieser Art beispielsweise in Logistik- und Produktionsumgebungen. Die Koordination der miteinander interagierenden Transportfahrzeuge erfolgt üblicherweise über eine zentrale Steuereinheit, welche Kollisionen der Fahrzeuge vorbeugt.

„Der Impuls, der zu der Bearbeitung dieses Projektes führte, ist der finanzielle und arbeitstechnische Aufwand bei der Umstrukturierung des Einsatzbereichs eines solchen Systems. Wird beispielsweise die Produktionsumgebung umgestellt, so müssen auch die Linienführungen entsprechend den neuen Gegebenheiten angepasst werden. Aus diesem Grund wird in dem oben genannten Projekt die Auslegung eines flexibleren Systems untersucht, welches unabhängig von solch externen Einflüssen kontinuierlich operieren kann“, berichtet Ingenieur Christoph Rohmann, Wissenschaftlicher Mitarbeiter am IFBW und Student im Masterstudiengang Fahrzeugsystemtechnologien.

Gefördert wird das Projekt mit rund 296.000 Euro vom Europäischen Fonds für regionale Entwicklung (EFRE) und erfolgt in enger Zusammenarbeit mit der Götting KG. „Mit diesem industriellen Projektpartner haben wir ein Unternehmen an unserer Seite, das bereits langjährige Erfahrung im Umgang mit hochautomatisierten Transportfahrzeugen hat. Neben der Entwicklung eigener Sensortechnologien hat sich das Unternehmen auf den Bereich der Transportsysteme mit fahrerlosen Seriennutzfahrzeugen im Außenbereich spezialisiert“, berichtet die Projektleitung. Der Projektstart fand im August 2018 statt. Mit einer Laufzeit von drei Jahren soll der geplante Projektabschluss im Juli 2021 sein.

Zwei Sensoren sehen mehr als einer

Als Basis für das Projekt SeLeTraSys hat die Götting KG ein Exemplar ihrer kleinen automatischen Transporteinheiten (KATE) zur Verfügung gestellt. Die KATE wird bereits serienmäßig in Produktionsumgebungen verwendet und basiert auf dem vorher beschriebenen Konzept der physischen Linienführungen mit zentralem Leitsystem. Das serienmäßige Transportsystem dient als Basis und wurde im Rahmen des bisherigen Projektverlaufs mit weiteren Komponenten, insbesondere mit Sensorik zur maschinellen Wahrnehmung, erweitert.

Um sich von den physischen Leitsystemen zu lösen, wird bordeigene Sensorik verwendet. Diese besteht aus einem Lidar-Sensor und einer Kamera. Als Kamera dient eine monochromatische Kamera der Firma IDS-Imaging. Da im Rahmen der Projektanforderungen keine Differenzierung verschiedener Farbmuster erforderlich ist, ist ein auf Graustufen basierter Sensor in diesem Fall die bessere Wahl, da die Datenmenge deutlich geringer und somit die Auswertung effizienter ist. Als Lidar-Sensor fungiert ein VLP-16 „Puck“ der Firma Velodyne. Auf Basis von 16 zweidimensionalen Ebenen wird ein sogenanntes 2.5D-Abbild der Umgebung aufgenommen. Der Sensor bietet einen horizontalen Öffnungswinkel von 360° bei einer maximalen Distanz von 100 Meter. Er ist somit auch für weitläufige Anwendungsbereiche geeignet.

Die Anbindung an das Transportfahrzeug erfolgt über eine Struktur, welche sich über Feststellhebel in der Längs- und Hochachse flexibel verschieben lässt. Auf diese Art und Weise können verschiedene Sensorpositionen untersucht werden, um auch experimentell eine optimale Ausrichtung für etwaige Serienanwendungen zu ermitteln (vgl. Abbildung 1).